ChatGPT的安全性挑战

关键要点

ChatGPT是一个强大的工具,但并不能取代专业安全人员,需要谨慎使用。精确度有限,使用者需要具备一定的提问技巧。可能增加编程人员的工作量,导致更多技术债务。存在泄露敏感信息的风险,组织需加强数据保护。随着ChatGPT的声名鹊起,它似乎无处不在。谷歌和微软也推出了自己的大语言模型LLMs版本,众多聊天机器人和相关技术正在积极开发中。由于生成性AI在媒体上引发了大量讨论,组织和个人都希望从这些技术中获益,IT安全公司自然也不例外。

水母npv下载尽管这一新兴技术有潜力使软件开发变得更加便利,但同样有可能成为对安全意识强的组织产生威胁的源头。以下是安全团队可能面临的四个威胁和挑战:

1 ChatGPT无法替代安全专家

该工具利用各种数学模型,从网络上获取大量文本和数据来生成回复。它并不是一个安全专家,只擅长查找人类安全专家发布的内容。然而,ChatGPT缺乏自主思考能力,往往受到用户选择的影响,这可能影响到安全领域的补救措施。尽管代码生成功能吸引人,但ChatGPT生成的代码并不具备资深安全专家的高水平复杂性。

2 ChatGPT的准确性有限

尽管关于其通过法学院入学考试和其他大学考试的宣传,ChatGPT的智能水平并不高。其数据库只更新到2021年,尽管时常有新数据上传。这对于及时提供最新的漏洞信息来说是一个大问题。此外,它回答的准确与否往往取决于用户如何描述问题和设置上下文。用户需要花时间优化提问,并通过与聊天机器人互动来提高自己的技能。

3 ChatGPT可能增加编程人员的工作量

它不能作为无代码解决方案或填补人才差距,因为非专家在使用这些技术时无法验证生成的建议是否合理。最终,ChatGPT会导致更多技术债务,因为安全专家必须审查任何AI生成的代码,以确保其有效性和安全性。

4 ChatGPT可能泄露敏感信息

从本质上讲,所有聊天机器人的输入都被用于不断重训练和改进自身模型。 ChatGPT可能会利用组织的漏洞,使黑客能够获取由聊天机器人生成的数据。我们已经看到一次早期的漏洞,用户的聊天记录被曝光。

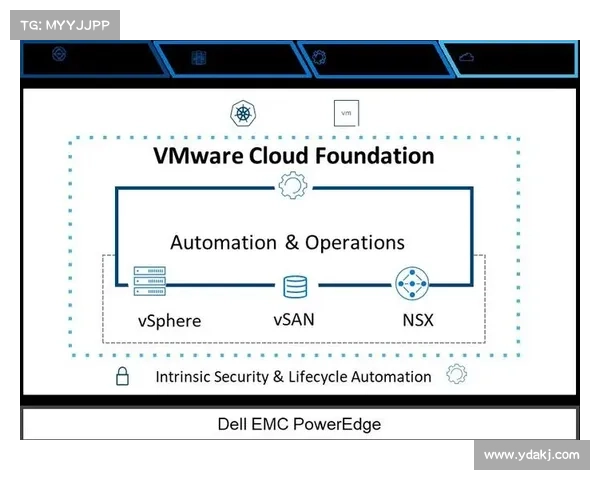

鉴于这些问题,IT安全经理应该采取何种措施来保护组织并降低风险?Gartner提供了一些具体建议,以更好地了解聊天机器人,并建议使用Azure版本进行实验,因为它不捕获敏感信息。他们还建议制定适当的政策,以防止机密数据上传到机器人,例如沃尔玛今年早些时候施行的政策。

IT经理还应努力开展更好、更具针对性的意识和培训项目。一位顾问建议使用聊天机器人生成示例培训信息。另一种技巧是生成关于网络安全威胁的报告和分析,让安全专家能够为公众重写。

随着ChatGPT持续引发关注,我们需要谨慎选择哪些技术值得接受。未来几年,投资重点可能会改变,隐私和合规团队将更依赖安全团队,以确保其隐私控制符合新规定。ChatGPT是否适合这一计划尚未可知。无论如何,安全分析师需权衡AI接口的优缺点,判断其整合风险是否值得。

Ron Reiter Sentra联合创始人和首席技术官